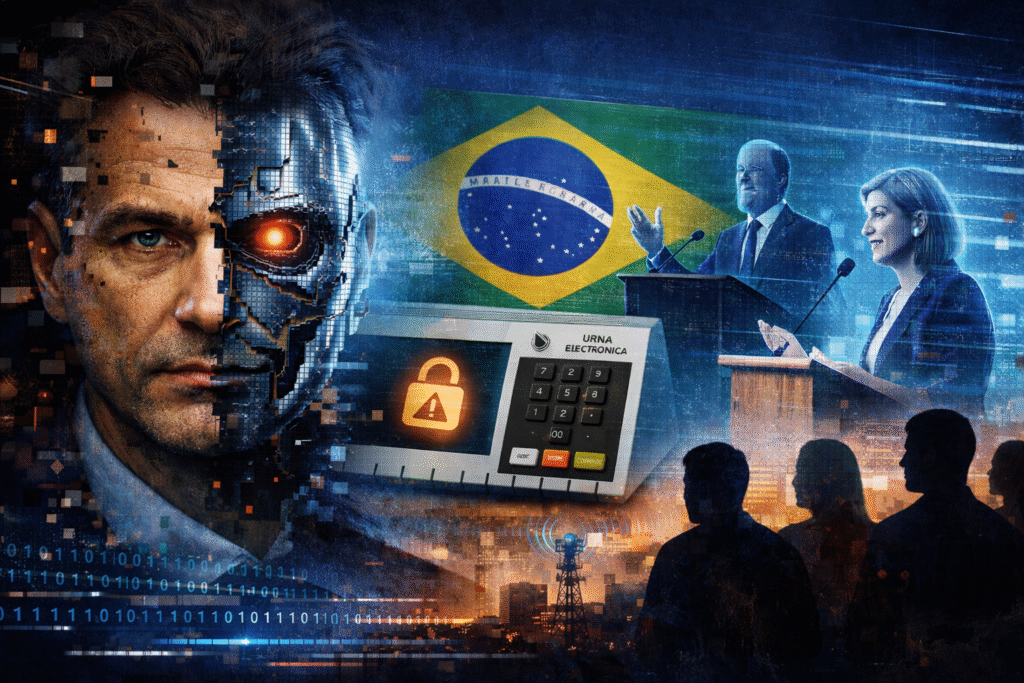

O avanço das tecnologias de inteligência artificial coloca um novo desafio no centro do debate democrático brasileiro: o uso de deepfakes, conteúdos hiper-realistas que simulam voz, rosto e gestos de pessoas reais para espalhar desinformação. Relatório “Identity Fraud Report 2025-2026”, da empresa Sumsub, aponta que os ataques com esse tipo de tecnologia cresceram 126% no Brasil apenas em 2025, com a produção de vídeos, áudios e documentos falsificados em larga escala.

A avaliação preocupa autoridades e especialistas, especialmente às vésperas das eleições presidenciais de 2026. Reportagem do portal R7 mostra que o uso de deepfakes deixou de ser apenas uma curiosidade tecnológica para se tornar um instrumento de fraude de identidade e potencial arma política.

O especialista em inteligência artificial Antônio Netto explica que a diferença entre uma imagem qualquer gerada por IA e um deepfake está na intenção de enganar: quando o recurso simula um rosto ou voz de alguém real para colocar falas ou ações que nunca aconteceram, o potencial de dano é muito maior. Segundo ele, há poucos anos era necessário um grande poder de processamento e conhecimento avançado para produzir um deepfake convincente; hoje, ferramentas acessíveis e até serviços prontos reduziram drasticamente essa barreira, gerando uma verdadeira “corrida armamentista” entre criadores de falsificações e sistemas de detecção. (R7)

Em 2024, o DFRLab (Digital Forensic Research Lab) já havia mapeado dezenas de conteúdos eleitorais brasileiros produzidos ou alterados por IA generativa nas eleições municipais, indicando que o fenômeno não é mais hipotético. A expectativa para 2026, segundo o próprio relatório, é de aumento significativo desses materiais, em um ambiente político altamente polarizado.

O Tribunal Superior Eleitoral (TSE) criou, em junho de 2024, um grupo de trabalho dedicado a analisar o impacto da inteligência artificial no processo eleitoral e propor medidas de combate à desinformação. Uma resolução da Justiça Eleitoral já proíbe o uso de IA para gerar conteúdos falsos nas campanhas, mas ainda não há um plano específico voltado aos deepfakes, justamente a tecnologia que mais desafia a percepção humana e os mecanismos de checagem tradicionais.

Para o advogado criminalista Arthur Richardisson, vice-presidente do Observatório Nacional da Abracrim, a norma vigente é “necessária, mas não suficiente”. Ele defende a criação de tipos penais específicos para deepfakes eleitorais, um marco legal de inteligência artificial que dialogue com o direito eleitoral e a regulação mais clara das plataformas digitais, sem violar garantias constitucionais como liberdade de expressão e devido processo legal. (R7)

Na prática, o desafio é equilibrar a proteção da integridade do voto com o respeito a direitos fundamentais. Plataformas, partidos, candidatos, órgãos de imprensa e o próprio eleitor terão de conviver, em 2026, com um cenário em que um vídeo “perfeito” pode ser completamente falso, e em que a checagem rápida e qualificada de informações passa a ser elemento central da disputa política.

Deixe um comentário